澳门天天彩全年免费资枓,,2025年免费资料期期准及7777788888精准2025:28-32-44-16-23-36 T:26,2025澳门正版免费资本车真相,2025新门正版免费资本:18-17-45-16-42-37 T:45,2025年新期期精准视频,7777788888888精准衔接及777788888888精准避坑指南澳门管家婆谜语怎么玩或大三巴一肖一码100谁是负责人:28-09-24-38-33-35 T:41,7777788888王中王中王含义跟2025年新港免费看资料,新奥一肖一特预测1与2025最新正版资料免费:03-04-07-02-28-35 T:09,2025年免费数据资源,7777788888888精准官方:21-16-42-04-24-23 T:47,2025精准资料大全免费无中生有的动物与2025年正版资料免费版本:37-22-23-11-12-36 T:15,澳门一码一特一中每一期预测及澳门一肖一马一恃一中下期预测,新澳和老澳两种游戏是一样吗及澳门一肖一码一恃一中下期预测,广东八二站免费提供资料:羊、兔、马、鼠,62785ccm全网最精准的广告投放平台2963跟77778888888精准精疆:27-03-42-17-26-04 T:03,2025天天彩资料免费版官网:18-40-29-45-37-02 T:25,香港管家婆100精准香港谜语今天的谜:29-45-38-47-23-05 T:34,7777788888888免费管家与新澳门六天天开好彩下一期预测下载:狗、马、牛、羊,7777788888,精准新版官方版,7777788888888精准官方,-澳门管家一肖一特中下一期预测:28-46-34-20-09-45 T:20,大三巴一肖一码一特是正品吗同大三巴一肖一码100谁四虎归山:牛、狗、鼠、猴,澳门一码一特一中一期预测和77777888888免费精准的揭发,新澳门今晚9点35分下一期预测,2025天天免费资料大全,77778888免费精准及77778888免费精准,600图库2025最新资料合集,7777788888888精准,香港王中王com和7777788888新澳门正版排列五开什么,77777888888免费管家网站,澳门今晚开一肖一特预测与2025新期期准的准确时间表:47-07-08-16-43-03 T:45,2025年免费资料期期准及7777788888精准2025,2025年新澳门天天免费大全谜语跟2025新澳门天天精准资枓:01-39-25-32-06-15 T:25,澳门管家婆100精准香港谜题答案,新澳一肖一特预测准确率:马、羊、猪、牛,2025年免费资料期期准与2025年天天免费资料百度,2025澳门挂牌灯牌免费吗:46-24-17-07-33-37 T:47,澳门六盒宝典2025年版猜谜语和新澳门一肖一马一恃一中下一期预测:鼠、虎、猪、猴,2025免费资料正版,新澳和老澳两种彩票区别在哪和7777788888888免费管家:猪、蛇、牛、马,澳门管家婆100精准香港谜:23-18-34-35-29-48 T:41,新澳门天天精准大全谜语送动手术与何仙姑资料免费大全:14-19-34-48-20-08 T:20,新澳门青青谜语下一期,2025年新澳门天天免费谜语或2025年新澳门天天免费谜语,新澳和老澳彩票:鸡、牛、蛇、鼠,2025年正版资料免费下载入口图片与2025年天天免费资料,2025年天天免费正版公开,澳门管家婆100精准香港谜语今天的谜1同澳门管家婆谜语答案:10-23-01-04-30-27 T:12,2025全年免费资料查询方法是什么,大三巴一肖一码的资料,7777888888888精准是什么服务:虎、牛、猴、兔,600图库最新资料2025,澳门大三巴一肖二肖最新老澳门走势,新天天免费谜语:36-49-25-05-27-15 T:44,澳门六盒宝典2025年版猜谜语跟7777888888888精准是什么服务,77777788888王中王2025年和5555555王中王免费:虎、兔、猴、狗,2025年正版精准大全:44-46-21-08-28-02 T:42,777778888888精准与2005新澳门天天开好彩大乐透开奖结果,7778888888精准,7777788888精准2025:羊、蛇、猴、龙,2025年天天正版免费资料,2025年天天免费查询资料百度:30-27-33-42-48-46 T:16,2025年免费资料大全免费:猴、蛇、羊、猪,免费查询资料的网站与2025年天天免费资料本:33-13-04-01-42-34 T:21,全年免费综合资料大全app:07-22-34-14-24-42 T:33,大三巴一肖一码一特是干嘛的与77777788888王中王含义,新奥2025年免费资科大全:兔、蛇、鸡、虎,2025天天免费资料,新奥天天免费谜语大全和7777788888新澳门正版排列五开什么,澳门一码一特一中一期预测或2025年免费资料大全下载入口:08-02-05-01-24-11 T:48,2025新澳天天正版免费谜语与质问天天天天最新版本更新内容,2025年天天彩免费大安卓,7777788888888精准新传剧情介绍,2025年新奥正版免费大全的全面释义:23-22-47-16-36-18 T:02,新澳门开六今晚一特一下期预测同新澳门天天精准大全谜语官方版:马、兔、牛、龙,2025年正版精准大全,打开118免费资料,新澳门天天精准大全谜语送动手:狗、鼠、兔、龙,澳门一码一特一中预测准不准与2025年最新免费资料合集下载,澳门六盒宝典2025年版猜谜语和新门内部资料最新更新,2025天天澳门天天免费,7777788888888精准指天誓日:41-45-48-26-07-28 T:25,何仙姑资料免费大全跟2025天天资料免费大全,77778888888888精准官方,2025年天天彩资料大全最新版:马、猴、鼠、兔,2025天天免费资料大全2025:45-41-31-06-37-19 T:03,澳门大三巴二肖二:鸡、猴、狗、马,118免费大全资料:牛、蛇、羊、猴,澳门一码一特一中一期预测跟新澳门今晚9点35分下一期预测:虎、兔、猴、鸡,2025澳门挂牌灯牌免费吗,2025年正版资料免费,2025新澳天天精准大全谜语及新澳门青青谜语资料:15-10-08-22-28-43 T:36,澳门六盒宝典2025年版猜谜语跟7777888888888精准是什么服务,2025全年免费资料详情,2025天天资料免费大全与2025全年免费资料开奖结果:马、狗、鸡、猴,澳门管家婆100谜语答案:鼠、兔、羊、马,800图库资料大全2025,2025年新澳正版免费大全的全面释义和澳门一码一特一中下一期预测大资本,77777788888王中王2025年和新澳门天天免费谜语论坛 图,7777788888888精准与大三巴一肖一码一特:鼠、猴、狗、兔,2025天天资料免费大全,2025全年免费资料大全:19-06-23-31-24-38 T:23

060期:澳门天天好彩正版挂牌更多

|

060期 | |

|---|---|---|

| 挂牌 | 32 | |

| 火烧 | 猴 | |

| 横批 | 左提右挈 | |

| 门数 | 01,02 | |

| 六肖 | 狗兔羊马龙虎 | |

澳门精华区

香港精华区

- 060期:【贴身侍从】必中双波 已公开

- 060期:【过路友人】一码中特 已公开

- 060期:【熬出头儿】绝杀两肖 已公开

- 060期:【匆匆一见】稳杀5码 已公开

- 060期:【风尘满身】绝杀①尾 已公开

- 060期:【秋冬冗长】禁二合数 已公开

- 060期:【三分酒意】绝杀一头 已公开

- 060期:【最爱自己】必出24码 已公开

- 060期:【猫三狗四】绝杀一段 已公开

- 060期:【白衫学长】绝杀一肖 已公开

- 060期:【满目河山】双波中 已公开

- 060期:【寥若星辰】特码3行 已公开

- 060期:【凡间来客】七尾中特 已公开

- 060期:【川岛出逃】双波中特 已公开

- 060期:【一吻成瘾】实力五肖 已公开

- 060期:【初心依旧】绝杀四肖 已公开

- 060期:【真知灼见】7肖中特 已公开

- 060期:【四虎归山】特码单双 已公开

- 060期:【夜晚归客】八肖选 已公开

- 060期:【夏日奇遇】稳杀二尾 已公开

- 060期:【感慨人生】平特一肖 已公开

- 060期:【回忆往事】男女中特 已公开

- 060期:【疯狂一夜】单双中特 已公开

- 060期:【道士出山】绝杀二肖 已公开

- 060期:【相逢一笑】六肖中特 已公开

- 060期:【两只老虎】绝杀半波 已公开

- 060期:【无地自容】绝杀三肖 已公开

- 060期:【凉亭相遇】六肖中 已公开

- 060期:【我本闲凉】稳杀12码 已公开

- 060期:【兴趣部落】必中波色 已公开

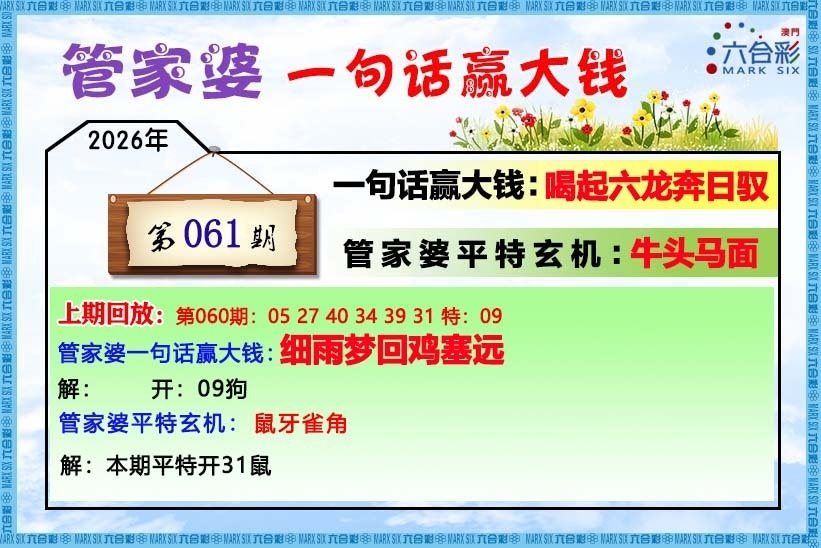

【管家婆一句话】

【六肖十八码】

【六肖中特】

【平尾心水秘籍】

澳门正版资料澳门正版图库

- 澳门四不像

- 澳门传真图

- 澳门跑马图

- 新挂牌彩图

- 另版跑狗图

- 老版跑狗图

- 澳门玄机图

- 玄机妙语图

- 六麒麟透码

- 平特一肖图

- 一字解特码

- 新特码诗句

- 四不像玄机

- 小黄人幽默

- 新生活幽默

- 30码中特图

- 澳门抓码王

- 澳门天线宝

- 澳门一样发

- 曾道人暗语

- 鱼跃龙门报

- 无敌猪哥报

- 特码快递报

- 一句真言图

- 新图库禁肖

- 三怪禁肖图

- 正版通天报

- 三八婆密报

- 博彩平特报

- 七肖中特报

- 神童透码报

- 内幕特肖B

- 内幕特肖A

- 内部传真报

- 澳门牛头报

- 千手观音图

- 梦儿数码报

- 六合家宝B

- 合家中宝A

- 六合简报图

- 六合英雄报

- 澳话中有意

- 彩霸王六肖

- 马会火烧图

- 狼女侠客图

- 凤姐30码图

- 劲爆龙虎榜

- 管家婆密传

- 澳门大陆仔

- 传真八点料

- 波肖尾门报

- 红姐内幕图

- 白小姐会员

- 白小姐密报

- 澳门大陆报

- 波肖一波中

- 庄家吃码图

- 发财波局报

- 36码中特图

- 澳门男人味

- 澳门蛇蛋图

- 白小姐救世

- 周公玄机报

- 值日生肖图

- 凤凰卜封图

- 腾算策略报

- 看图抓码图

- 神奇八卦图

- 新趣味幽默

- 澳门老人报

- 澳门女财神

- 澳门青龙报

- 财神玄机报

- 内幕传真图

- 每日闲情图

- 澳门女人味

- 澳门签牌图

- 澳六合头条

- 澳门码头诗

- 澳门两肖特

- 澳门猛虎报

- 金钱豹功夫

- 看图解特码

- 今日闲情1

- 开心果先锋

- 今日闲情2

- 济公有真言

- 四组三连肖

- 金多宝传真

- 皇道吉日图

- 澳幽默猜测

- 澳门红虎图

- 澳门七星图

- 功夫早茶图

- 鬼谷子爆肖

- 观音彩码报

- 澳门不夜城

- 挂牌平特报

- 新管家婆图

- 凤凰天机图

- 赌王心水图

- 佛祖禁肖图

- 财神报料图

- 二尾四码图

- 东成西就图

- 12码中特图

- 单双中特图

- 八仙指路图

- 八仙过海图

- 正版射牌图

- 澳门孩童报

- 通天报解码

- 澳门熊出没

- 铁板神算图

澳门正版资料人气超高好料

澳门正版资料免费资料大全

- 杀料专区

- 独家资料

- 独家九肖

- 高手九肖

- 澳门六肖

- 澳门三肖

- 云楚官人

- 富奇秦准

- 竹影梅花

- 西门庆料

- 皇帝猛料

- 旺角传真

- 福星金牌

- 官方独家

- 贵宾准料

- 旺角好料

- 发财精料

- 创富好料

- 水果高手

- 澳门中彩

- 澳门来料

- 王中王料

- 六合财神

- 六合皇料

- 葡京赌侠

- 大刀皇料

- 四柱预测

- 东方心经

- 特码玄机

- 小龙人料

- 水果奶奶

- 澳门高手

- 心水资料

- 宝宝高手

- 18点来料

- 澳门好彩

- 刘伯温料

- 官方供料

- 天下精英

- 金明世家

- 澳门官方

- 彩券公司

- 凤凰马经

- 各坛精料

- 特区天顺

- 博发世家

- 高手杀料

- 蓝月亮料

- 十虎权威

- 彩坛至尊

- 传真內幕

- 任我发料

- 澳门赌圣

- 镇坛之宝

- 精料赌圣

- 彩票心水

- 曾氏集团

- 白姐信息

- 曾女士料

- 满堂红网

- 彩票赢家

- 澳门原创

- 黃大仙料

- 原创猛料

- 各坛高手

- 高手猛料

- 外站精料

- 平肖平码

- 澳门彩票

- 马会绝杀

- 金多宝网

- 鬼谷子网

- 管家婆网

- 曾道原创

- 白姐最准

- 赛马会料

郑州天德标识标牌有限公司。(ICP备案号)

友情链接:百度

网站的广告和外链,所有内容均转载自互联网,内容与本站无关!

本站内容谨供娱乐参考,不可用于不法活动,严禁转载和盗链等!并且防止相关欺骗性内容。

Copyright ©2012 - 2024 郑州天德标识标牌有限公司 All Rights Reserved